BaixaCharla ao vivo #8: Racismo Algorítmico

A oitava BaixaCharla ao vivo, quinta de 2021, vai falar sobre racismo algorítmico a partir de “Comunidades, Algoritmos e Ativismos Digitais: Olhares Afrodiaspóricos“, organizado pelo nosso convidado da conversa, Tarcízio Silva, que é pesquisador, produtor cultural e mestre em Comunicação e Cultura Contemporâneas pela UFBA, doutorando em Ciências Humanas e Sociais na UFABC, onde estuda imaginários sociotécnicos de resistência, e Tech + Society Fellow pela Fundação Mozilla, atuando em promoção de segurança digital e defesa contra danos algorítmicos. Também atua como curador na Desvelar, entre outras atividades que podem ser conferidas em seu currículo.

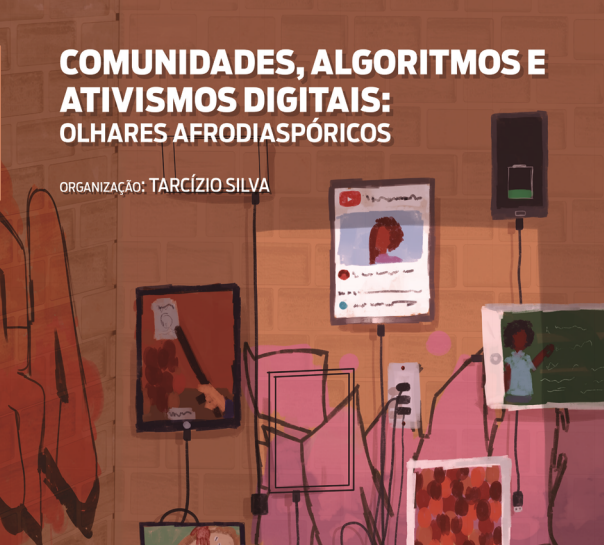

Editado em 2020 pela Literarua, “Comunidades, Algoritmos e Ativismos Digitais: Olhares Afrodiaspóricos” busca relacionar raça, racismo, negritude e branquitude com os estudos de tecnologias digitais, especialmente algoritmos, mídias sociais e comunidades online. Reúne 14 artigos de pesquisadores/as provenientes do Brasil, países da Afrodiáspora e África, como Congo, Etiópia, Gana, Nigéria, Colômbia, Estados Unidos e Reino Unido. É uma publicação que, com sua diversidade de perspectivas, tenta suprir uma lacuna nos estudos acadêmicos brasileiros na área.

No prefácio, Emicida escreve que “se a essência das redes sociais é a conectividade, está para nascer uma que cumpra seu papel com mais eficácia do que um tambor”. É importante desnaturalizar a ideia de que “tecnologia, storytelling, minimalismo e ideias que visam ampliar a percepção do que significa ser humano sejam apenas invenções do vale do silício”, diz o rapper, que cita Paulina Chiziane, “às vezes sinto que nos oferecem algo que já era nosso antes deles chegarem”.

O capítulo de abertura é de Ruha Benjamin, autora de “Race After Technology: Abolitionist Tools for the New Jim Code” (2019), ativista e professora da Universidade de Princeton, nos Estados Unidos. Nesse texto, Ruha incentiva um compromisso de incorporar abordagens raciais críticas no campoos Estudos de Ciência e Tecnologia – Science and Technology Studies (STS), no inglês. Como ela escreve: “seja na arquitetura de máquinas (…) ou na arquitetura de tecnologias legais, os pesquisadores de STS devem treinar nossas ferramentas analíticas sobre as diferentes formas de “correção racial” que sustentam uma forma perniciosa de construção do conhecimento”. A tecnologia é um dos muitos meios pelos quais as formas anteriores de desigualdade são atualizadas, por isso, ela explica, a necessidade vital de se fazer um balanço rotineiro também das ferramentas conceituais que são usadas para entender a dominação racial.

Nos outros 12 textos, o livro colabora com a crescente complexificação do pensamento sobre a comunicação digital e internet resultante da diversificação dos olhares e falas nos espaços acadêmicos. “Da matemática na divinação Ifá ao ativismo político, os temas e objetos dos capítulos passam por transição capilar, blackfishing, afroempreendedorismo, Black Twitter, contra-narrativas ao racismo e métodos digitais de pesquisa apropriados à complexidade das plataformas, algoritmos e relações de poder incorporadas nas materialidades digitais racializadas”, como escreve Tarcízio na apresentação.

É do nosso convidado da BaixaCharla o artigo no livro que complexifica o tema em voga no debate: “Racismo Algorítmico em plataformas digitais: microagressões e discriminações em código”. Para ele, o racismo online é um “sistema de práticas contra pessoas racializadas que privilegiam e mantém poder político, econômico e cultural para os brancos no espaço digital” (citando Tynes, Lozada, Smith & Stewart, 2019). Nos ambientes digitais, especialmente plataformas de publicidade (Facebook), de nuvem e computação (Amazon Web Services, Microsoft Azure, etc), de produto (como Zipcar etc), plataformas lean (Uber, AirBnB), o desafio se torna mais profundo na medida em que o racismo adentra os processos automatizados “invisíveis” como recomendação de conteúdo, reconhecimento facial e processamento de imagens.

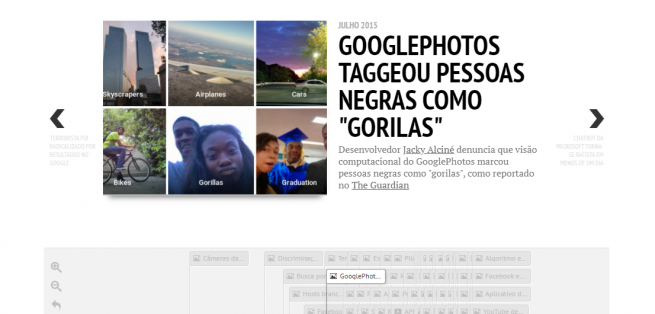

Nesse cenário em que a tecnologia cada vez mais é tanto mediação das atividades humanas quanto interação interpessoal e negociação de serviços e comércio, os casos de identificação de racismo algorítmico passam a ser somados por diversas pesquisadoras, ativistas e desenvolvedores – entre eles o próprio Tarcízio, com sua Linha do tempo do racismo algorítmico, projeto paralelo de sua pesquisa no doutorado (intitulado provisoriamente de “Dados, Algoritmos e Racialização em Plataformas Digitais”) que incorpora casos de 2010 a partir da pergunta: “Como as plataformas digitais, mídias sociais, aplicativos e inteligência artificial reproduzem (e intensificam) o racismo nas sociedades?”

O artigo também fala de chamadas “microagressões”, “ofensas verbais, comportamentais e ambientais comuns, sejam intencionais ou não intencionais, que comunicam desrespeito e insultos hostis, depreciativos ou negativos contra pessoas de cor” (Sue, 2010a, p. 29). São expressões, consciente ou não, usadas para manter “aqueles à margem racial em seus lugares” e que mostram como o racismo é sistemático em nossa sociedade. No texto, o pesquisador identifica sete tipos dessas microagressões: Suposição de Criminalidade; Negação de Realidades Raciais/Democracia Racial; Suposição de Inferioridade Intelectual; Patologização de Valores Culturais; Exotização; Estrangeiro na Própria Terra / Negação de Cidadania; Exclusão ou Isolamento.

Outro tema em voga na discussão sobre racismo e plataformas digitais são as tecnologias baseadas em inteligência artificial para ordenação e vigilância de cidadãos no espaço público. Conhecidas como “tecnologias de reconhecimento facial”, elas ganharam mercado nos últimos anos tanto a partir do lobby das big techs quanto pelo avanço de ideologias de extrema-direita. Por conta disso, têm sido usadas (ou contratadas para serem) em polícias de diversos lugares, entre eles o Brasil; um estudo do Intervozes afirma que “dentre os 26 prefeitos de capitais empossados em janeiro de 2021, 17 apresentaram propostas que, de algum modo, preveem o uso das tecnologias de informação e comunicação na segurança pública”. Publicamos em nossas redes uma notícia da Folha de S. Paulo nesta semana que conta que 20 estados brasileiros, das cinco regiões do Brasil, utilizam ou estão implementando a tecnologia de reconhecimento facial na segurança pública local.

Na Linha do Tempo citada há diversos casos de erros dessas tecnologias. Há, por exemplo, situações em que os sistemas de reconhecimento facial da Amazon e da IBM erram mais em imagens de mulheres negras, assim como sistemas de biometria visual costumam falhar de 10 a 100 vezes mais com imagens de pessoas negras ou asiáticas. Por conta dessas falhas que ajudam a perpetuar o racismo algorítmico, pesquisadores têm defendido o seu banimento; nos Estados Unidos, há decisões como a de Minneapolis, cidade onde Geroge Floy foi morto, onde Câmara Municipal vetou o uso da tecnologia pela polícia, por sinais de que a I.A. é tendenciosa contra negros e outros grupos raciais. Na Europa, o Comitê Europeu de Proteção de Dados (EDPB) e a Autoridade Europeia para a Proteção de Dados (EDPS), apresentaram opinião conjunta que sugere o banimento do reconhecimento de pessoas em espaços públicos.

Tarcízio recentemente participou do podcast Tecnopolítica em que conversou com Sueli Carneiro (e Sérgio Amadeu, âncora do podcast) sobre o tema, resgatando inclusive o questionamento à neutralidade da ciência moderna – Sueli lembrou de como a ciência tem origem racista, tendo por base um pensamento universal europeu colonizador que excluía os povos africanos e as diversas cosmologias ameríndias e asiáticas.

O pesquisador também escreveu em seu blog sobre 10 razões para as tecnologias de reconhecimento facial serem banidas. Estão entre eles o reconhecimento facial e visão computacional são técnicas altamente imprecisas, em especial sobre pessoas racializadas; de como as tecnologias digitais vistas como “neutras” ou “objetivas” favorecem ainda mais excessos de policiais, e no espaço público pressupõe e fortalecem uma sociedade vigilantista. Também é fator para defender o banimento o fato de que não podemos pressupor boa-fé de corporações de tecnologia, como exemplifica casos como o impacto do Facebook no Brexit e nas eleições americanas, do extremismo digital no YouTube e do lobby da Google no Conselho Administrativo de Defesa Econômica, entre muitos outros.

No aspecto econômico, mesmo o custo-benefício para captura de condenados não justifica a coleta massiva, como exemplifica a milionária implementação de reconhecimento facial em Londres, onde bases reuniam fotos de mais de 2.400 suspeitos que geraram apenas 8 prisões. Dados proporcionais ainda piores foram reportados no Brasil, onde gigantesca infraestrutura de reconhecimento facial foi implementada na Micareta de Feira de Santana, Bahia, coletando e vulnerabilizando 1,3 milhões de rostos para o cumprimento de apenas 18 mandados.

Para debater o livro e os temas citados, Leonardo Foletto e Tatiana Balistieri, do BaixaCultura, conversam com Tarcízio Silva no dia 22 de julho, às 19h, no canal do Youtube do BaixaCultura, onde as outras charlas já estão disponíveis. Nas próximas semanas ela também vira podcast, que pode ser escutado aqui e nas principais plataformas de streaming. Essa é a última charla do ciclo de 2021 que discutiu diferentes perspectivas dos estudos das tecnologias de comunicação no Brasil e no mundo.

*

Você pode assistir aqui, em áudio e vídeo (YouTube).

Deixe um comentário