O olho do mestre: a automação da inteligência geral

No final de 2023, não lembro onde nem como, fiquei sabendo de “The Eye of the Master”, novo livro do Matteo Pasquinelli sobre IA. Fiquei na hora empolgado. Primeiro porque a proposta do livro é a de contar uma “história social” da IA, indo desde Charles Babbage até hoje, passando e destrinchando o conceito […]

Criação e cultura livre na era da inteligência artificial generativa

No final do 2023, publiquei um artigo chamado “Criação e cultura livre na era da inteligência artificial generativa” na revista acadêmica Aurora, da PUC-SP, no Dossiê “Inteligência Artificial: questões éticas e estéticas”[ parte 1; parte 2]. É um primeiro texto mais filosófico, em que faço uma revisão de bibliografia (acadêmica, mas também jornalístic

Crises e ressacas em poéticas fronteiriças de Minas Gerais

Depois de alguns anos de trocas nas redes, finalmente conheci as experimentações arte tecnológicas do LabFront no 8º Congresso Internacional de Arte, Ciência e Tecnologia e Seminário de Artes Digitais, realizado no final de junho em BH. Organizado por uma rede de grupos de pesquisa desde 2015, o seminário esse ano falou de “Crises” […]

Inteligência artificial generativa e direitos culturais

Publicado originalmente em Artica por Jorge Gemetto e Mariana Fossati em duas partes: 1º em 28/5/2023 e 2º em 5 de junho de 2023. Traduzido e adaptado do espanhol por Leonardo Foletto. PARTE 1: Alguém quer pensar nas pessoas usuárias? A partir da disponibilidade de ferramentas como DALL-E, Stable Diffusion ou Midjourney para geração […]

Como o ChatGPT está influenciando na disputa pelo controle do conhecimento

É quase impossível identificar retroativamente as fontes e autorias retiradas sem autorização de bases de dados pelos bots. Apropriação do saber comum pode estar mais ameaçada – abrindo uma disputa sobre os direitos do autor Por Leonardo Foletto* O ano de 2023 tem sido permeado pelo tema de Inteligência Artificial (IA) quando se fala sobre […]

Uma nova primavera para o direito Autoral das IAs

As tecnologias de IA atingiram um nível de popularidade nunca antes visto. Como essa nova onipresença afeta o uso justo e a criação de novas obras? Por Lukas Ruthes Gonçalves* O primeiro inverno da IA aconteceu em 1974, depois que um relatório encomendado pelo Conselho de Pesquisa Científica do Reino Unido criticou como a […]

Unheimlich: A Espiral do Caos e o Autômato Cognitivo

Por Franco “Bifo” Berardi* Tradução: desobediente** Publicado originalmente em 10/3/2023 no e-flux A palavra alemã “unheimlich” é difícil de traduzir. “Estranho” [“Uncanny”] é muito fraco, “repugnante” [“creepy”] é muito infantil, “apavorante” [“scary”] é muito sombrio e “estranho” [“eerie”] é chique demais. “Sinistro” [“Sinister”] se

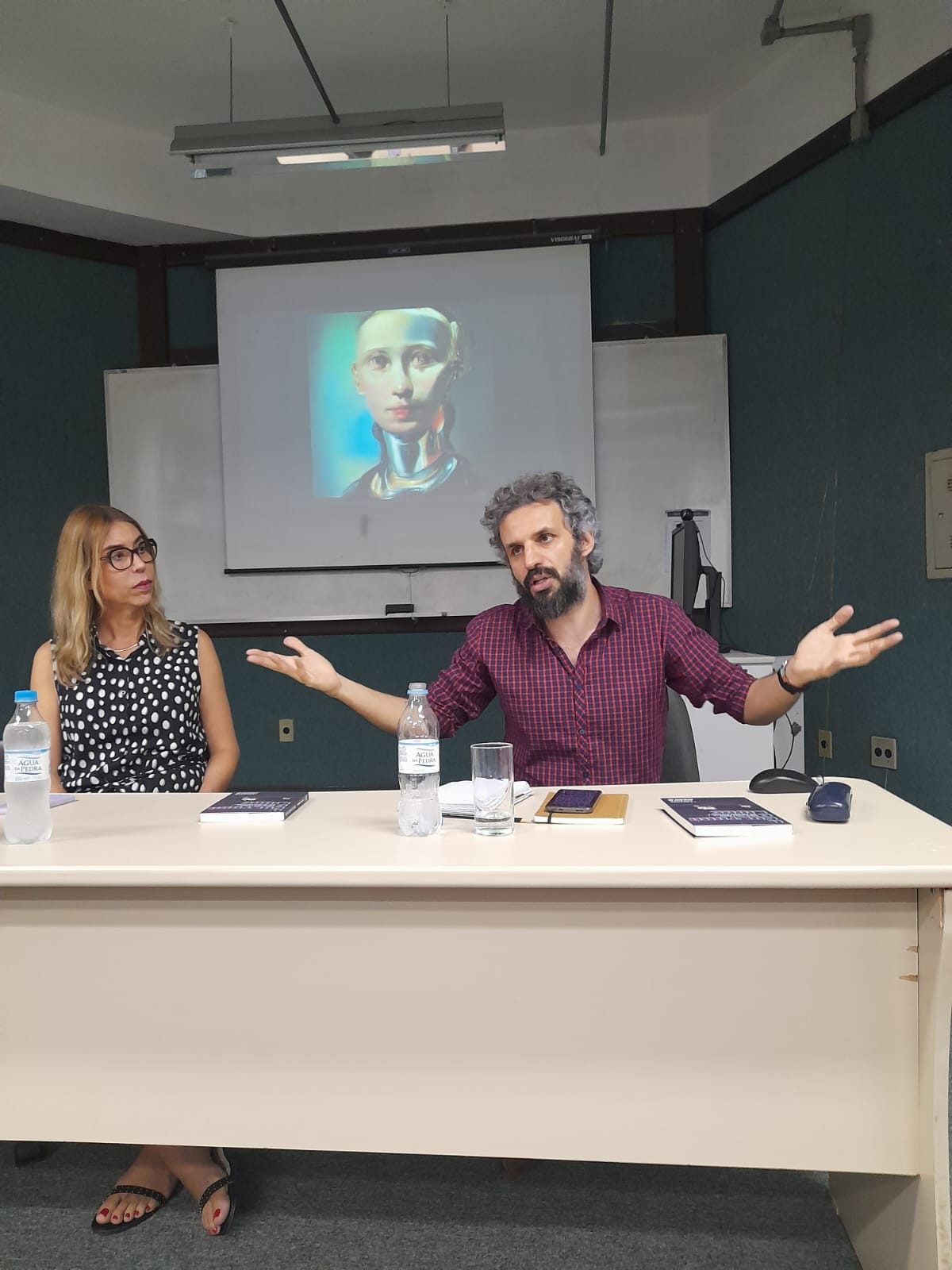

Comunicação, cultura livre e cópia na era da Inteligência Artificial

“Olá pessoal, uma alegria estar aqui com vocês*, exatos 6 anos depois de ter defendido minha tese, neste mesmo PPGCOM, especialmente com Alê Primo, que acompanhou meu doutorado e fez parte da minha banca de qualificação e defesa, e Laura Wöttrich, amiga e colega de comunicação há mais de uma década. A tese, a […]

A vertiginosa ascensão das IAs e do ChatGPT em 2023

Faz umas quatro semanas que parei para começar a escrever sobre os diversos links que todo dia chegavam (e continuam chegando) pra mim sobre IAs e o ChatGPT. Quando parava pra ler um chegava outro texto, e outro, outro, cada um mais “definitivo” do que outro, apocalípticos e desdenhosos, otimistas e proféticos, de perspectivas […]

2023: o que esperar do cenário digital?

No final de 2022 conversei no Podcast Tecnopolítica com Sérgio Amadeu – professor da UFABC, ciberativista histórico e parceiro de várias frentes de batalha – sobre o que esperar no cenário da tecnologia em 2023. O papo buscou responder a pergunta: o que esperar de 2023 no cenário digital? Listei alguns pontos de atenção, […]